科技媒體 marktechpost 于 10 月 24 日發(fā)布博文,報道稱微軟公司宣布開源 OmniParser,是一款解析和識別屏幕上可交互圖標的 AI 工具。

項目背景

傳統(tǒng)的自動化方法通常依賴于解析 HTML 或視圖層次結構,從而限制了其在非網(wǎng)絡環(huán)境中的適用性。

而包括 GPT-4V 在內的現(xiàn)有的視覺語言模型(VLMs),并不擅長解讀復雜 GUI 元素,導致動作定位不準確。

項目簡介

微軟為了克服這些障礙,推出了 OmniParser,是一種純視覺基礎的工具,旨在填補當前屏幕解析技術中的空白。

該工具并不需要依賴額外的上下文數(shù)據(jù),可以理解更復雜的圖形用戶界面(GUI),是智能 GUI 自動化領域的一項令人興奮的進展。

OmniParser 結合可交互區(qū)域檢測模型、圖標描述模型和 OCR 模塊等,不需要 HTML 標簽或視圖層次結構等顯式基礎數(shù)據(jù),能夠在桌面、移動設備和網(wǎng)頁等上跨平臺工作,提高用戶界面的解析準確性。

OmniParser 除了識別屏幕上的元素,還能將這些元素轉換成結構化的數(shù)據(jù)。

測試表現(xiàn)

OmniParser 在多個基準測試中顯示出優(yōu)越的性能。例如,在 ScreenSpot 數(shù)據(jù)集中,其準確率提高了 73%,顯著超越依賴 HTML 解析的模型。

這一設計不僅能生成類似文檔對象模型(DOM)的結構化表示,還能通過疊加邊界框和功能標簽來引導語言模型做出更準確的用戶動作預測。

同時,GPT-4V 在使用 OmniParser 輸出后,圖標的正確標記率從 70.5% 提升至 93.8%。這些改進表明,OmniParser 能夠有效解決當前 GUI 交互模型的根本缺陷。

OmniParser 的發(fā)布不僅拓寬了智能體的應用范圍,也為開發(fā)者提供了一個強大的工具,助力創(chuàng)建更智能、更高效的用戶界面驅動智能體。微軟目前已在 Hugging Face 上發(fā)布 OmniParser,普及這一前沿技術,將進一步推動多模態(tài) AI 的發(fā)展,特別是在無障礙、自動化和智能用戶輔助等領域。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據(jù)此操作,風險自擔。

海報生成中...

海藝AI的模型系統(tǒng)在國際市場上廣受好評,目前站內累計模型數(shù)超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創(chuàng)作風格。

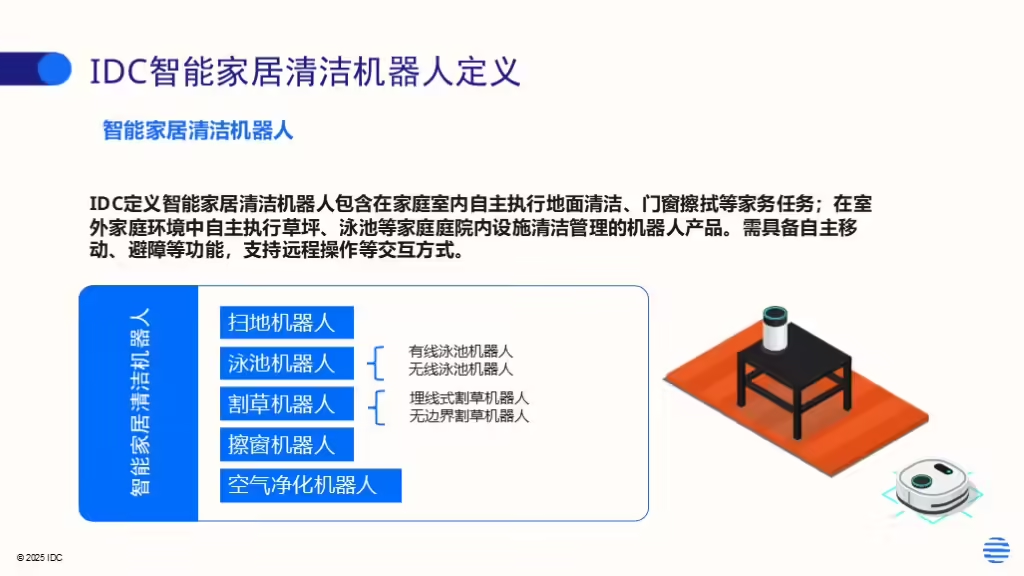

IDC今日發(fā)布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。