ĪĪĪĪOpenAI ╣½╦Šė┌ 8 į┬ 13 ╚š░l(f©Ī)▓╝ą┬┬äĖÕŻ¼ą¹▓╝═Ų│÷ SWE-bench Verified ┤·┤a╔·│╔įu(p©¬ng)╣└╗∙£╩(zh©│n)Ż¼ĮŌøQ┴╦┤╦Ū░Ą─ŠųŽ▐ąįå¢Ņ}Ż¼─▄ē“Ė³£╩(zh©│n)┤_Ąžįu(p©¬ng)╣└╚╦╣żųŪ─▄─Żą═į┌▄ø╝■╣ż│╠╚╬äš(w©┤)ųąĄ─▒Ē¼F(xi©żn)ĪŻ

ĪĪĪĪSWE-bench

ĪĪĪĪūóŻ║SWE-Bench ╩Ūę╗éĆ(g©©)ė├ė┌įu(p©¬ng)╣└ LLM ĮŌøQ GitHub ╔ŽšµīŹ(sh©¬)▄ø╝■å¢Ņ}─▄┴”Ą─╗∙£╩(zh©│n)£y(c©©)įćöĄ(sh©┤)ō■(j©┤)╝»ĪŻ

ĪĪĪĪ╦³╩š╝»┴╦üĒūį 12 éĆ(g©©)┴„ąąĄ─ Python é}ÄņĄ─ 2294 éĆ(g©©) Issue-Pull Request ī”(du©¼)ĪŻį┌£y(c©©)įćĢr(sh©¬)Ż¼LLM Ģ■(hu©¼)─├ĄĮę╗éĆ(g©©)┤·┤aÄņ║═ issue ├Ķ╩÷Ż¼╚╗║¾╔·│╔ę╗éĆ(g©©)ča(b©│)ČĪüĒĮŌøQ issue ├Ķ╩÷Ą─å¢Ņ}ĪŻ

ĪĪĪĪįō╗∙£╩(zh©│n)╩╣ė├ā╔ĘNŅÉą═Ą─£y(c©©)įćŻ║

ĪĪĪĪFAIL_TO_PASS £y(c©©)įćė├ė┌Öz▓ķå¢Ņ}╩ŪʱęčĄ├ĄĮĮŌøQ

ĪĪĪĪPASS_TO_PASS £y(c©©)įćė├ė┌┤_▒Ż┤·┤aĖ³Ė─▓╗Ģ■(hu©¼)ŲŲē─¼F(xi©żn)ėą╣”─▄ĪŻ

ĪĪĪĪSWE-bench Ą─å¢Ņ}

ĪĪĪĪOpenAI ųĖ│÷┴╦ SWE-bench Ą─╚²éĆ(g©©)ų„ę¬å¢Ņ}Ż║

ĪĪĪĪå╬į¬£y(c©©)įć▀^ė┌ć└(y©ón)Ė±Ż║ė├ė┌įu(p©¬ng)╣└ĮŌøQĘĮ░Ėš²┤_ąįĄ─å╬į¬£y(c©©)įć═∙═∙▀^ė┌Š▀¾wŻ¼ėąĢr(sh©¬)╔§ų┴┼cå¢Ņ}¤oĻP(gu©Īn)Ż¼▀@┐╔─▄ī¦(d©Żo)ų┬Š▄Į^š²┤_Ą─ĮŌøQĘĮ░ĖĪŻ

ĪĪĪĪå¢Ņ}├Ķ╩÷▓╗├„┤_Ż║įSČÓśė▒ŠĄ─å¢Ņ}├Ķ╩÷▓╗ē“Š▀¾wŻ¼ī¦(d©Żo)ų┬å¢Ņ}╩Ū╩▓├┤ęį╝░æ¬(y©®ng)╚ń║╬ĮŌøQ║¼║²▓╗ŪÕĪŻ

ĪĪĪĪķ_░l(f©Ī)Łh(hu©ón)Š│ļyęįįO(sh©©)ų├Ż║ėąĢr(sh©¬)║▄ļy┐╔┐┐Ąž×ķ┤·└ĒįO(sh©©)ų├ SWE-bench ķ_░l(f©Ī)Łh(hu©ón)Š│Ż¼Å─Č°¤oęŌųąī¦(d©Żo)ų┬å╬į¬£y(c©©)įć╩¦öĪĪŻ

ĪĪĪĪSWE-bench Verified

ĪĪĪĪSWE-bench Verified Ą─ų„ę¬Ė─▀M(j©¼n)ų«ę╗╩Ū╩╣ė├╚▌Ų„╗» Docker Łh(hu©ón)Š│ķ_░l(f©Ī)┴╦ą┬Ą─įu(p©¬ng)╣└╣żŠ▀░³ĪŻ

ĪĪĪĪ▀@ę╗Ė─▀M(j©¼n)ų╝į┌╩╣įu(p©¬ng)╣└▀^│╠Ė³╝ėę╗ų┬║═┐╔┐┐Ż¼ĮĄĄ═┼cķ_░l(f©Ī)Łh(hu©ón)Š│įO(sh©©)ų├ŽÓĻP(gu©Īn)Ą─å¢Ņ}░l(f©Ī)╔·Ą─┐╔─▄ąįĪŻ

ĪĪĪĪ└²╚ńŻ¼GPT-4o ĮŌøQ┴╦ 33.2% Ą─śė▒ŠŻ¼Č°▒Ē¼F(xi©żn)ūŅ╝čĄ─ķ_į┤┤·└Ē┐“╝▄ Agentless Ą─Ą├ĘųĘŁ┴╦ę╗Ę¼Ż¼▀_(d©ó)ĄĮ 16%ĪŻ

ĪĪĪĪąį─▄Ą─╠ßĖ▀▒Ē├„Ż¼SWE-bench Verified Ė³║├Ąž▓ČūĮĄĮ┴╦╚╦╣żųŪ─▄─Żą═į┌▄ø╝■╣ż│╠╚╬äš(w©┤)ųąĄ─šµš²─▄┴”ĪŻ

ĪĪĪĪ╬─š┬ā╚(n©©i)╚▌āH╣®ķåūxŻ¼▓╗śŗ(g©░u)│╔═Č┘YĮ©ūhŻ¼šł(q©½ng)ųö(j©½n)╔„ī”(du©¼)┤²ĪŻ═Č┘Yš▀ō■(j©┤)┤╦▓┘ū„Ż¼’L(f©źng)ļU(xi©Żn)ūįō·(d©Īn)ĪŻ

║Żł¾(b©żo)╔·│╔ųą...

║Ż╦ćAIĄ──Żą═ŽĄĮy(t©»ng)į┌ć°(gu©«)ļH╩ął÷(ch©Żng)╔ŽÅV╩▄║├įu(p©¬ng)Ż¼─┐Ū░šŠā╚(n©©i)└█ėŗ(j©¼)─Żą═öĄ(sh©┤)│¼▀^80╚féĆ(g©©)Ż¼║Ł╔wīæīŹ(sh©¬)ĪóČ■┤╬į¬Īó▓Õ«ŗĪóįO(sh©©)ėŗ(j©¼)Īóözė░Īó’L(f©źng)Ė±╗»łDŽ±Ą╚ČÓŅÉą═æ¬(y©®ng)ė├ł÷(ch©Żng)Š░Ż¼╗∙▒ŠĖ▓╔w╦∙ėąų„┴„äō(chu©żng)ū„’L(f©źng)Ė±ĪŻ

9į┬9╚šŻ¼ć°(gu©«)ļHÖÓ(qu©ón)═■╩ął÷(ch©Żng)š{(di©żo)čąÖC(j©®)śŗ(g©░u)ėóĖ╗┬³(Omdia)░l(f©Ī)▓╝┴╦ĪČųąć°(gu©«)AIįŲ╩ął÷(ch©Żng)Ż¼1H25ĪĘł¾(b©żo)ĖµĪŻųąć°(gu©«)AIįŲ╩ął÷(ch©Żng)░ó└’įŲš╝▒╚8%╬╗┴ąĄ┌ę╗ĪŻ

9į┬24╚šŻ¼╚A×ķ└żņ`š┘ķ_Ī░ųŪ─▄¾w“×(y©żn)Ż¼ę╗Ų┴ĄĮ╬╗Ī▒╚A×ķIdeaHubŪ¦ąą░┘śI(y©©)¾w“×(y©żn)╣┘ėŗ(j©¼)äØ░l(f©Ī)▓╝Ģ■(hu©¼)ĪŻ

č┼±R╣■ū“╚šą¹▓╝═Ų│÷ā╔┐ŅŅ^┤„╩ĮČ·ÖC(j©®)Ż¼Ęųäe╩ŪŲĮ░Õš±─żĄ─YH-4000║═äė(d©░ng)╚”įŁ└ĒĄ─YH-C3000ĪŻ

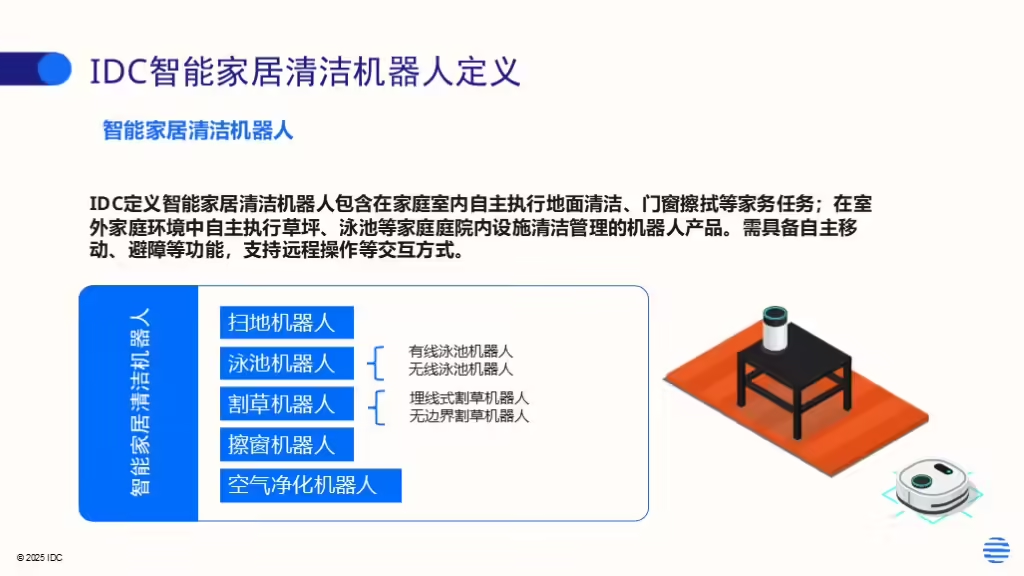

IDCĮ±╚š░l(f©Ī)▓╝Ą─ĪČ╚½Ū“ųŪ─▄╝ęŠėŪÕØŹÖC(j©®)Ų„╚╦įO(sh©©)éõ╩ął÷(ch©Żng)╝ŠČ╚Ė·█Öł¾(b©żo)ĖµŻ¼2025─ĻĄ┌Č■╝ŠČ╚ĪĘ’@╩ŠŻ¼╔Ž░ļ─Ļ╚½Ū“ųŪ─▄╝ęŠėŪÕØŹÖC(j©®)Ų„╚╦╩ął÷(ch©Żng)│÷žø1,2╚f┼_(t©ói)Ż¼═¼▒╚į÷ķL(zh©Żng)33%Ż¼’@╩Š│÷ŲĘŅÉÅŖ(qi©óng)ä┼Ą─╩ął÷(ch©Żng)ąĶŪ¾ĪŻ