近期,GPT-4V的開源替代方案在中國的頂尖學府清華、浙大等的推動下,出現了一系列性能優異的開源視覺模型。其中,LLaVA、CogAgent和BakLLaVA是三種備受關注的開源視覺語言模型。

LLaVA是一個端到端訓練的多模態大模型,它將視覺編碼器和用于通用視覺和語言理解的Vicuna相結合,具備令人印象深刻的聊天能力。而CogAgent是在CogVLM基礎上改進的開源視覺語言模型,擁有110億個視覺參數和70億個語言參數。

另外,BakLLaVA是使用LLaVA1.5架構增強的Mistral7B基礎模型,已經在多個基準測試中優于LLaVA213B。這三種開源視覺模型在視覺處理領域具有極大的潛力。

LLaVA在視覺聊天和推理問答方面表現出接近GPT-4水平的能力。在視覺聊天方面,LLaVA的表現相對于GPT-4的評分達到了85%,在推理問答方面更是達到了92.53%的超過GPT-4的新SoTA。LLaVA在回答問題時,能夠全面而有邏輯地生成回答,并且可以以JSON格式輸出。

它不僅可以從圖片中提取信息并回答問題,還可以將圖片轉化為JSON格式。LLaVA還可以識別驗證碼、識別圖中的物體品種等,展現出了強大的多模態能力。在性能上接近GPT-4的情況下,LLaVA具有更高的成本效益,訓練只需要8個A100即可在1天內完成。

CogAgent作為在CogVLM基礎上改進的開源視覺語言模型,擁有更多的功能和性能優勢。它支持更高分辨率的視覺輸入和對話答題,能夠處理超高分辨率圖像輸入。

CogAgent還提供了可視化代理的能力,能夠返回任何給定任務的計劃、下一步行動和帶有坐標的具體操作。它還增強了與圖形用戶界面相關的問題解答功能,可以處理與網頁、PC應用程序、移動應用程序等任何圖形用戶界面截圖相關的問題。另外,通過改進預培訓和微調,CogAgent還增強了OCR相關任務的能力。這些功能的提升使得CogAgent在多個基準測試上實現了最先進的通用性能。

BakLLaVA是使用LLaVA1.5架構增強的Mistral7B基礎模型,具備更好的性能和商用能力。BakLLaVA在多個基準測試中優于LLaVA213B,并且可以在某些數據上進行微調和推理。雖然BakLLaVA在訓練過程中使用了LLaVA的語料庫,不允許商用,但BakLLaVA2則采用了更大的數據集和更新的架構,超越了當前的LLaVA方法,具備商用能力。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據此操作,風險自擔。

海報生成中...

海藝AI的模型系統在國際市場上廣受好評,目前站內累計模型數超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創作風格。

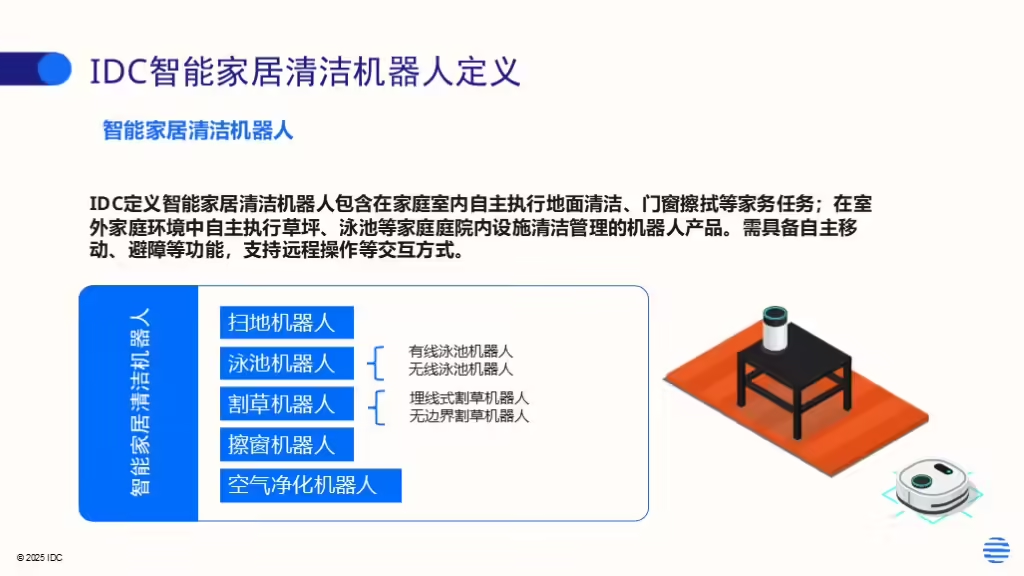

IDC今日發布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。