在人工智能領域,DeepSeek-R1的推出引發了廣泛關注,這一創新代表了 AI 產業的顛覆性進展。其多頭潛在注意力網絡(Multi-head Latent Attention,MLA)架構,借助低秩壓縮技術顯著降低了訓練與推理的成本,甚至僅為同等性能大模型的十分之一。這一成果由復旦大學 NLP 實驗室的博士后紀燾及其團隊共同完成,目標是讓任意預訓練的大語言模型能夠快速遷移到 MLA 架構,而無需重新從頭開始訓練。

目前,主流大模型普遍基于標準的多頭注意力機制(MHA)及其變種,這些模型在推理成本上相較于 MLA 存在顯著劣勢。因此,研究團隊提出了 MHA2MLA 框架,旨在通過兩個關鍵步驟 —— 部分 RoPE 保留和鍵值聯合表示低秩近似,成功實現 MHA/GQA 架構向 MLA 的遷移。

在 MHA2MLA 的實施過程中,團隊首先通過部分 RoPE 微調策略,將位置編碼從大維度中分離,保留了與位置相關的少量維度,解決了 MLA 和 RoPE 之間的沖突。接著,通過奇異值分解(SVD)技術對鍵值向量進行低秩近似,以最大化保留預訓練知識,同時顯著減少緩存空間。實驗結果表明,僅需使用預訓練數據的0.3% 至0.6% 進行微調,便能基本恢復遷移過程中的性能損失。

在與其他高效推理技術結合后,例如4-bit KV 緩存量化,Llama2-7B 模型的 KV 緩存減少了92.19%,而性能損失僅為0.5%。這一成果展現了 MHA2MLA 框架在壓縮技術上的優越兼容性,同時保持了模型的推理能力和長上下文處理能力,為部署資源高效的大語言模型提供了一條新的可行路徑。

然而,研究團隊也指出,實驗受到硬件條件的限制,尚未覆蓋如 Llama3等需進行128K 長上下文微調的模型。未來的研究將聚焦于擴展至更多模型架構,并結合參數高效微調策略,進一步降低遷移過程中的參數更新規模。

文章內容僅供閱讀,不構成投資建議,請謹慎對待。投資者據此操作,風險自擔。

海報生成中...

海藝AI的模型系統在國際市場上廣受好評,目前站內累計模型數超過80萬個,涵蓋寫實、二次元、插畫、設計、攝影、風格化圖像等多類型應用場景,基本覆蓋所有主流創作風格。

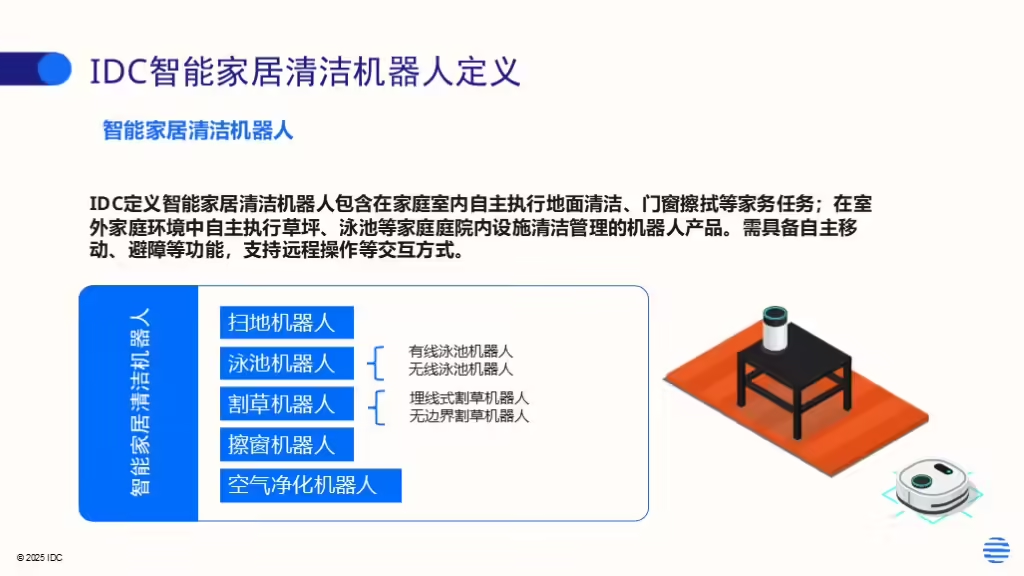

IDC今日發布的《全球智能家居清潔機器人設備市場季度跟蹤報告,2025年第二季度》顯示,上半年全球智能家居清潔機器人市場出貨1,2萬臺,同比增長33%,顯示出品類強勁的市場需求。