本文來自于微信公眾號(hào) AIGC開放社區(qū)(ID:AIGCOPEN),作者:AIGC開放社區(qū)。

在長(zhǎng)文本場(chǎng)景中,ChatGPT等大語言模型經(jīng)常面臨更高算力成本、更長(zhǎng)的延遲以及更差的性能。為了解決這三大難題,微軟開源了LongLLMLingua。

據(jù)悉,LongLLMLingua的核心技術(shù)原理是將“文本提示”實(shí)現(xiàn)最高20倍的極限壓縮,同時(shí)又可以準(zhǔn)確評(píng)估提示中內(nèi)容與問題的相關(guān)程度,消除無關(guān)內(nèi)容保留關(guān)鍵信息,達(dá)到降本增效目的。

實(shí)驗(yàn)結(jié)果顯示,經(jīng)過LongLLMLingua壓縮后的提示,比原始提示的性能提升了17.1%,同時(shí)輸入GPT-3.5-Turbo的tokens減少了4倍。在LongBench和ZeroScrolls測(cè)試中顯示,每1,000個(gè)樣本節(jié)省28.5美元和27.4美元的成本。

當(dāng)壓縮約10k tokens的提示,壓縮率在2-10倍范圍內(nèi)時(shí),端到端延遲可以降低1.4-3.8倍,顯著加速了推理速率。

從介紹論文來看,LongLLMLingua主要由問題感知的粗細(xì)粒度壓縮、文檔重排序、動(dòng)態(tài)壓縮比率和壓縮后子序列恢復(fù)4大模塊組成。

問題感知的粗粒度壓縮模塊

該模塊的設(shè)計(jì)思路是,使用問題文本進(jìn)行條件化,評(píng)估每個(gè)段落與問題的相關(guān)程度,保留相關(guān)度更高的段落。

具體來說,通過計(jì)算問題文本與各段落的條件困惑度,判斷二者的邏輯關(guān)聯(lián)程度,條件困惑度越低表示相關(guān)性越高。

在此基礎(chǔ)上,設(shè)置閾值保留困惑度較低的段落,過濾掉與問題不相關(guān)的段落。這實(shí)現(xiàn)了根據(jù)問題快速移除大量冗余信息的粗粒度壓縮。

文檔重排序模塊

研究表明,在提示中,靠近開始和結(jié)束位置的內(nèi)容對(duì)語言模型的影響最大。所以該模塊根據(jù)各段落的相關(guān)程度對(duì)其進(jìn)行重新排序,使關(guān)鍵信息出現(xiàn)在對(duì)模型更敏感的位置,減少中間位置信息損失。

通過利用粗粒度壓縮模塊計(jì)算出的各段落與問題的關(guān)聯(lián)度,對(duì)段落進(jìn)行排序,使關(guān)聯(lián)度最高的段落排在最前面。這進(jìn)一步增強(qiáng)了模型對(duì)關(guān)鍵信息的感知。

在獲取重排序后的相關(guān)段落后,需要進(jìn)一步壓縮每個(gè)段落內(nèi)的詞量。此時(shí)動(dòng)態(tài)壓縮比率模塊對(duì)提示進(jìn)行精細(xì)調(diào)控。

動(dòng)態(tài)壓縮比率模塊

對(duì)更相關(guān)的段落使用更低的壓縮比率,分配更多的保留詞語預(yù)算,而對(duì)相關(guān)性較弱的段落則使用更高的壓縮比率。

通過利用粗粒度壓縮結(jié)果中的段落關(guān)聯(lián)度,動(dòng)態(tài)確定每個(gè)段落的壓縮比率。關(guān)聯(lián)度最高的段落壓縮比率最低,依次類推。

實(shí)現(xiàn)自適應(yīng)、細(xì)粒度的壓縮控制,有效保留關(guān)鍵信息。壓縮后還需要提高結(jié)果的可靠性,這就需要下面的壓縮后子序列恢復(fù)模塊。

壓縮后子序列恢復(fù)模塊

在壓縮過程中,一些關(guān)鍵詞可能被過度刪除,影響信息的完整性,而該模塊可以檢測(cè)并恢復(fù)這些關(guān)鍵詞。

工作原理是,利用源文本、壓縮文本、生成文本之間的子序列關(guān)系,從生成結(jié)果中恢復(fù)完整的關(guān)鍵名詞詞組,修復(fù)壓縮帶來的信息缺失,提高結(jié)果的準(zhǔn)確性。

整個(gè)過程有點(diǎn)像我們快速瀏覽文章、篩選信息、整合要點(diǎn)的工作流程等,使模型快速捕捉文本的關(guān)鍵信息,生成高質(zhì)量的摘要。

LongLLMLingua實(shí)驗(yàn)數(shù)據(jù)

研究人員構(gòu)建了一個(gè)基于Natural Questions的多文檔問答數(shù)據(jù)集,其中每個(gè)示例包含一個(gè)問題及20個(gè)相關(guān)文檔,并需要從這20個(gè)文檔中查找到答案。

該數(shù)據(jù)集模擬了實(shí)際的搜索引擎和問答場(chǎng)景,可以評(píng)估模型在長(zhǎng)文檔中的問答性能。

此外,研究人員還采用了更為通用的長(zhǎng)文本理解基準(zhǔn)測(cè)試集,包括LongBench和ZeroSCROLLS,以評(píng)估方法在更廣泛場(chǎng)景下的效果。

其中,LongBench覆蓋單文檔問答、多文檔問答、文本摘要、少樣本學(xué)習(xí)等任務(wù),包含英文數(shù)據(jù)集。ZeroSCROLLS則包括文本摘要、問答理解、情感分析等典型語言理解任務(wù)。

在這些數(shù)據(jù)集上,研究人員比較了LongLLMLingua壓縮后的提示與原始提示在大語言模型上的性能。同時(shí),也與其他提示壓縮方法進(jìn)行了對(duì)比,如基于困惑度的LLMLingua和基于檢索的方法,評(píng)估了LongLLMLingua的有效性。

實(shí)驗(yàn)結(jié)果顯示,LongLLMLingua壓縮后的提示在問答準(zhǔn)確率、生成文本質(zhì)量等指標(biāo)上普遍優(yōu)于原始提示。

例如,在NaturalQuestions上,壓縮4倍的提示提升了17.1%的問答準(zhǔn)確率。當(dāng)壓縮約10k tokens的提示,壓縮率在2-10倍范圍內(nèi)時(shí),端到端延遲可以降低1.4-3.8倍。這充分證明LongLLMLingua可以在壓縮提示的同時(shí)提升關(guān)鍵信息提取。

文章內(nèi)容僅供閱讀,不構(gòu)成投資建議,請(qǐng)謹(jǐn)慎對(duì)待。投資者據(jù)此操作,風(fēng)險(xiǎn)自擔(dān)。

海報(bào)生成中...

海藝AI的模型系統(tǒng)在國(guó)際市場(chǎng)上廣受好評(píng),目前站內(nèi)累計(jì)模型數(shù)超過80萬個(gè),涵蓋寫實(shí)、二次元、插畫、設(shè)計(jì)、攝影、風(fēng)格化圖像等多類型應(yīng)用場(chǎng)景,基本覆蓋所有主流創(chuàng)作風(fēng)格。

9月9日,國(guó)際權(quán)威市場(chǎng)調(diào)研機(jī)構(gòu)英富曼(Omdia)發(fā)布了《中國(guó)AI云市場(chǎng),1H25》報(bào)告。中國(guó)AI云市場(chǎng)阿里云占比8%位列第一。

9月24日,華為坤靈召開“智能體驗(yàn),一屏到位”華為IdeaHub千行百業(yè)體驗(yàn)官計(jì)劃發(fā)布會(huì)。

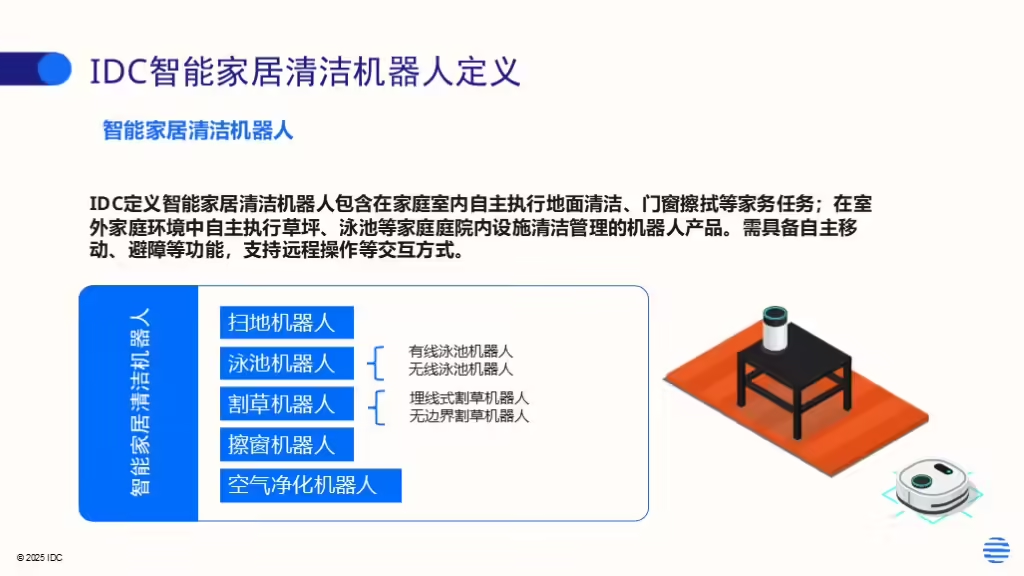

IDC今日發(fā)布的《全球智能家居清潔機(jī)器人設(shè)備市場(chǎng)季度跟蹤報(bào)告,2025年第二季度》顯示,上半年全球智能家居清潔機(jī)器人市場(chǎng)出貨1,2萬臺(tái),同比增長(zhǎng)33%,顯示出品類強(qiáng)勁的市場(chǎng)需求。